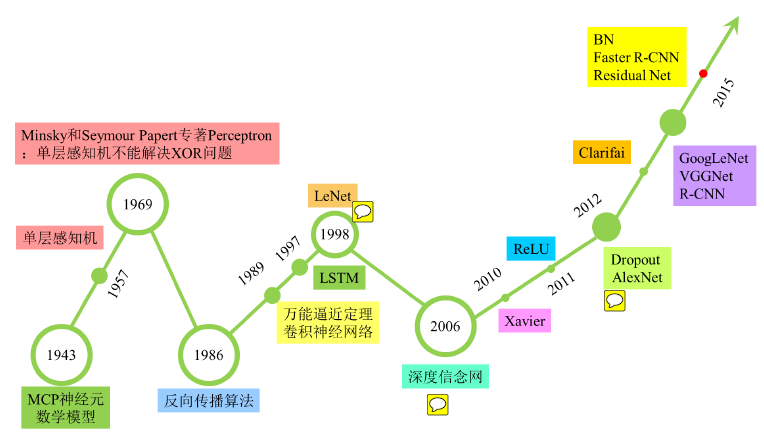

三 ChatGPT的底层逻辑极其复杂,但如果要简化为3个最核心的元素,ChatGPT-4认为它们可能是:1、深度学习:ChatGPT的核心是一个基于 Transformer 的深度学习模型。 Transformer模型通过自注意力(Self-Attention)机制来捕获输入文本中的复杂模式。在训练过程中,模型通过反向传播和梯度下降等优化算法来学习这些模式,使得它能够生成自然、连贯、与输入相符的文本。 2、大数据:ChatGPT通过训练海量的文本数据来学习语言模型。 数据集包含了各种语言模式和语境,使模型能够在各种情况下生成合适的文本。大数据在这里起到了决定性的作用。 3、强大的计算能力:为了处理这些大量的数据和复杂的深度学习模型,ChatGPT需要强大的计算能力。 这包括强大的硬件(如高性能的GPU),优秀的计算框架(如TensorFlow和PyTorch),以及高效的并行和分布式计算技术。 以上三个元素构成了ChatGPT的基础,使得它能够学习和生成自然语言。 但是,这只是表面上的逻辑。实际上,每一个环节背后都有深厚的理论基础,涵盖了机器学习、自然语言处理、计算机科学、数学等多个学科的知识。 深度学习是一种强大的机器学习方法,其底层逻辑相当复杂。不过,如果尝试将深度学习核心原理简化为3个要素,ChatGPT-4认为可以这样描述: 1、神经网络架构:深度学习的核心是深度神经网络,这是一种模拟人脑工作原理的计算模型。 神经网络由多个相互连接的层组成,每一层都由大量的神经元(或称为节点)组成。每个神经元都会接收前一层神经元的输入,并进行一定的计算,然后将结果传递给下一层的神经元。 2、权重优化和学习:神经网络的每个连接都有一个权重,代表这个连接的重要性。 深度学习的目标就是通过训练数据来调整这些权重,使得网络的输出尽可能接近于真实的目标值。这个过程通常通过优化算法(如梯度下降)实现,算法会根据网络输出与目标值之间的差距(损失)来调整权重。 3、非线性激活函数:深度学习的另一个关键元素是非线性激活函数,如ReLU(Rectified Linear Unit)或Sigmoid等。 这些函数用于增加神经网络的表达能力,使其可以学习和表示非线性的复杂模式。 这三个要素共同构成了深度学习的底层逻辑。 需要注意的是:这只是一个粗略的概述,实际上深度学习涉及的理论和技术要远比这复杂得多。 例如,还有正则化、卷积神经网络、循环神经网络、自注意力机制、批归一化、优化算法、损失函数设计等等多种方法和技术,都是深度学习不可或缺的一部分。 以下是神经网络发展的完整历史(图中并不完整),其中数度起伏。

显然,我是用ChatGPT-4完成了这一节的内容。 人类的大脑可以自己思考自己,虽然谜团难解; 神经网络也能回忆自己的历史,尽管它无法为那些为此进程添砖加瓦的人类而感动。 四 Chris McCormick认为,神经网络是纯粹的数学。从技术上讲,“机器学习”模型在很大程度上基于统计数据。它们估计所有选项的概率,即使所有选项的正确概率都极低,它们仍然只会选择概率最高的路径。 神经网络的灵感来源于生物学,特别是人脑的工作原理,但其设计和操作基础确实是数学,包括线性代数(用于数据和权重的表示和操作)、微积分(用于优化算法,如梯度下降)和概率论(用于理解和量化不确定性)。 神经网络的每个部分都可以用数学表达式来描述,训练过程则是通过优化数学目标函数(损失函数)来学习模型参数的过程。 黄仁勋说:“AI既是深度学习,也是一种解决难以指定的问题的算法。这也是一种开发软件的新方法。想象你有一个任意维度的通用函数逼近器。”在黄仁勋的比喻中,“通用函数逼近器”确实是对深度神经网络的一个精确且富有洞见的描述。这个比喻突出了深度神经网络的核心特性:它们可以学习并逼近任意复杂的函数映射,只要网络足够深,参数足够多。这种“函数逼近”的能力使得深度学习能够应对各种各样的任务,从图像分类和语音识别到自然语言理解和生成,甚至是更复杂的任务,如游戏和决策制定。 只要我们有足够的数据来训练这些模型,神经网络就能学习到这些任务背后的复杂模式。–哪怕这些模式对人类而言只是一个黑盒子。尤其在生成式模型(如ChatGPT)中,这种“函数逼近”的能力使得模型能够生成富有创造性的输出,如编写文章、创作诗歌或音乐等。这些模型通过学习大量的数据,理解语言或音乐的规则,然后生成符合这些规则的新的创作。 ChatGPT到底在做什么?为什么它能够成功? 大神Wolfram对此解释道:令人惊奇的是,ChatGPT尝试写一篇文章时,基本上只是一次又一次地询问“在已有的文本基础上,下一个单词应该是什么?” ,然后每次都添加一个单词。(更准确地说是一个token) 那么,是否每次都选取概率最大的那个单词呢? 并非简单如此。 Wolfram告诉了我们ChatGPT如何靠概率来“写”出一篇文章:

概率和随机性,再次显示出神奇的魔力。 |

|手机版|小黑屋|博士驿站:连接全球智慧,共创博士人才生态圈

( 浙ICP备2023018861号-3 )平台提供新鲜、免费、开放、共享的科技前沿资讯、博士人才招聘信息和科技成果交流空间。

平台特别声明:线上内容(如有图片或视频亦包括在内)来自网络或会员发布,均已备注来源;本站资讯仅提供信息和存储服务。Notice: The content above (including the pictures and videos if any) is uploaded and posted by user , which is a social media platform and only provides information storage services.

|手机版|小黑屋|博士驿站:连接全球智慧,共创博士人才生态圈

( 浙ICP备2023018861号-3 )平台提供新鲜、免费、开放、共享的科技前沿资讯、博士人才招聘信息和科技成果交流空间。

平台特别声明:线上内容(如有图片或视频亦包括在内)来自网络或会员发布,均已备注来源;本站资讯仅提供信息和存储服务。Notice: The content above (including the pictures and videos if any) is uploaded and posted by user , which is a social media platform and only provides information storage services.

GMT+8, 2026-3-10 19:50

Powered by Discuz! X3.5

© 2001-2024 Discuz! Team.